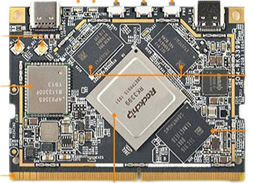

| CPU |

SOC:RK3399 核心:64位双核Cortex-A72 +四核Cortex-A53 频率:Cortex-A72 (2.0 ghz), Cortex-A53 (1.5 ghz) |

| GPU | Mali-T864 GPU,支持OpenGL ES1.1/2.0/3.0/3.1、OpenVG1.1 OpenCL, DX11, AFBC |

| VPU | 4K VP9 and 4K 10bits H265/H264 60fps decoding, Dual VOP, etc |

| Memory | RAM: Dual-Channel 4GB DDR3 |

| Storage | eMMC: 16GB(regular), 32GB/64GB(optional), eMMC 5.1 |

| Power Management | RK808-D PMIC,配合独立直流/直流,启用dvf solfware省电,RTC唤醒,系统睡眠模式 |

| Connectivity |

以太网:本机千兆以太网 wi - fi: 802.11 a / b / g / n / ac 蓝牙:4.1双模式 天线:双天线接口 |

| Video Input | 1个或两个4-Lane MIPI-CSI,双重ISP, 13 mpix / s,同时支持双相机数据的输入 |

| Video Output |

HDMI: HDMI 2.0a, supports 4K@60Hz,HDCP 1.4/2.2 DP on Type-C: DisplayPort 1.2 Alt Mode on USB Type-C LCD Interface: one eDP 1.3(4-Lane,10.8Gbps), one or two 4-Lane MIPI-DSI |

| USB |

USB 2.0: 2独立的本地主机USB 2.0 USB 3.0: 1本地主机USB 3.0 USB c类型:支持USB3.0 c型和显示端口1.2 Alt模式USB c型 |

| PCIe | PCIe x4, compatible with PCIe 2.1, Dual operation mode |

| 调试 | 1 x调试UART, 3 v级,1500000个基点 |

| LED | 1x Power LED(Red) 1x GPIO LED(Green) |

| Key | Power Key x1 Reset Key x1 Recovery Key x1 |

| 工作温度 | -20℃ to 70℃ |

| 电源 | 直流12 v / 1(边缘连接器)或DV 5 v / 2.5 (c型) |

|

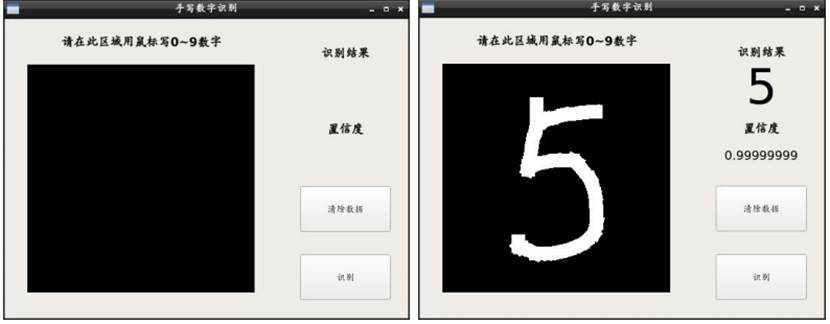

图:手写字识别案例

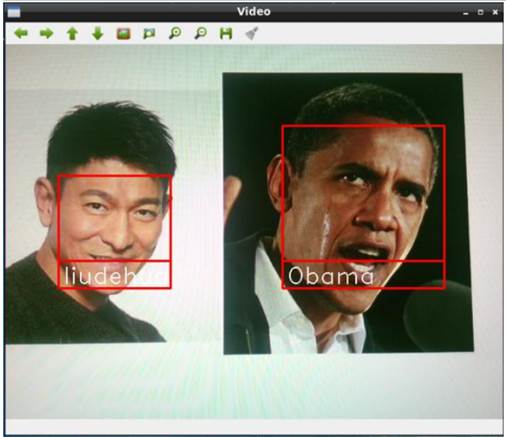

图: 人脸识别案例

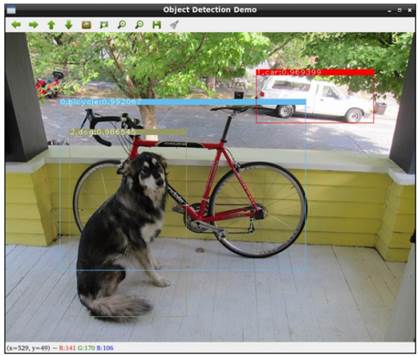

图:目标检测案例

图:人体姿态识别案例

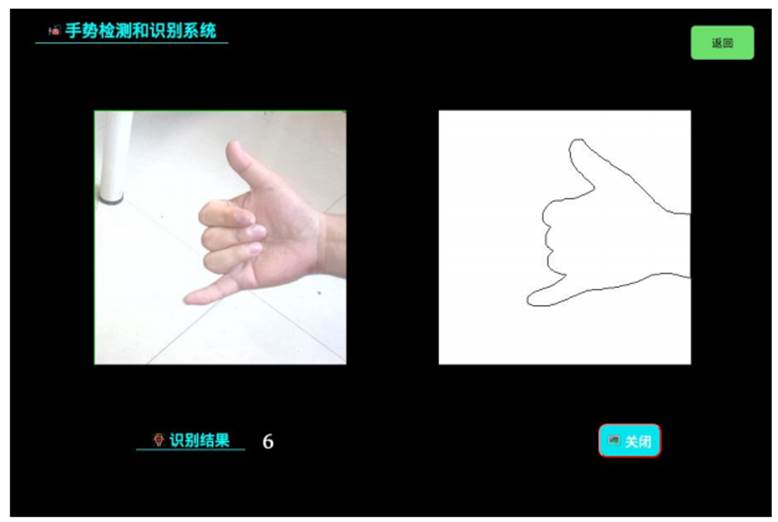

图:手势检测和识别系统案例

图:交通门禁车牌检测和识别系统案例

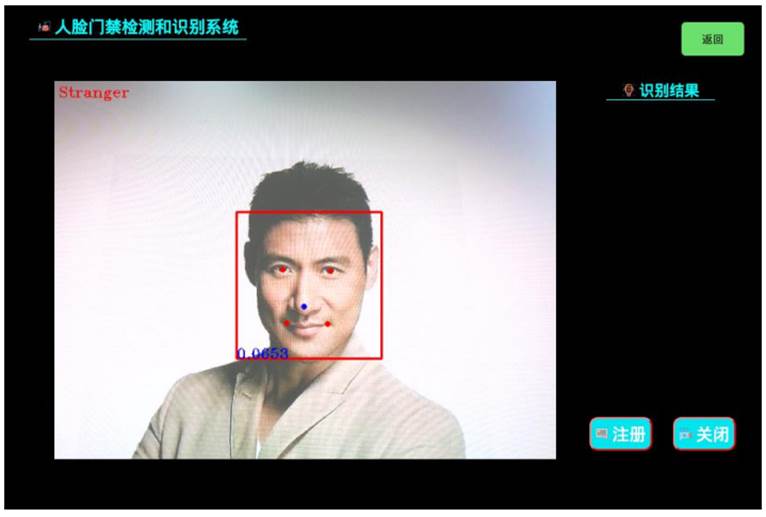

图:人脸门禁检测和识别系统案例

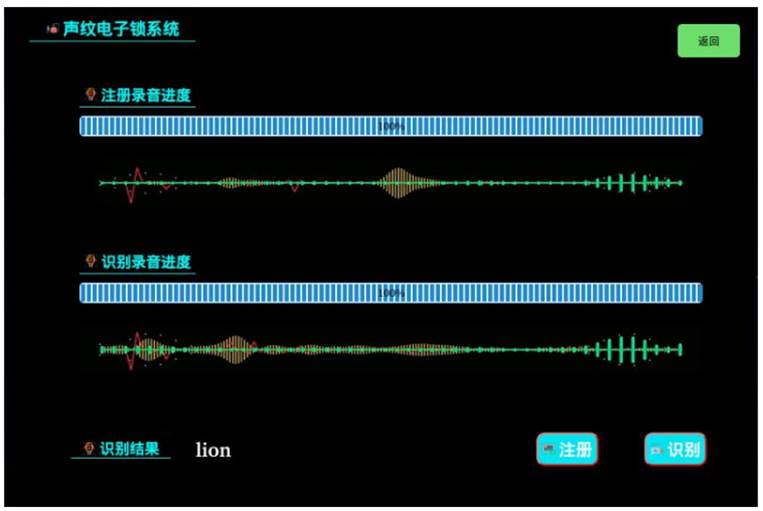

图:声纹电子锁系统案例

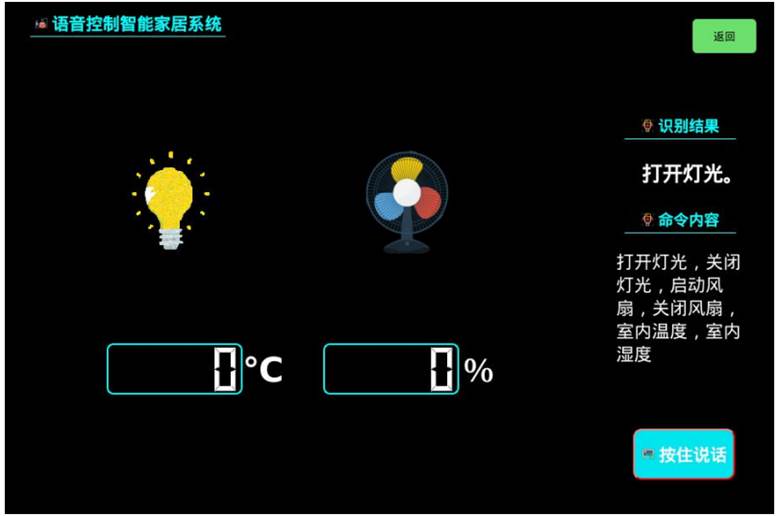

图:语音控制智能家居系统案例

图:知识图谱和文本聊天机器人系统案例